Humanoide Roboter versprechen viel. Sie sollen in der Pflege helfen, Kaffee servieren können und in der Industrie in Fabriken arbeiten. Doch zwischen Marketing, technischer Realität und Kosten klaffen große Lücken. Wir schauen im Input auf Chinas ambitionierte Robotik-Strategie, auf deutsche und amerikanische Gegenentwürfe und auf den Einfluss moderner KI-Modelle, die Robotern erstmals echtes Lernen ermöglichen sollen.

Links zur Episode

- Den Werbespot von Antrophic findet ihr auf YouTube

- Das Video zu Moya gibt es ebenfalls auf YouTube

Transkript der Episode

Das Transkript wird automatisiert erstellt

Jingles:

Silicon Weekly Silicon Weekly war's für heute.

Caspar:

Hallo und herzlich willkommen zu Silicon Weekly. Hallo liebe Hörerinnen und Hörer und hallo Elli.

Elli:

Hallo.

Caspar:

Ja, an der Stelle liebe Grüße an Stella, die macht nämlich alles richtig, die Urlaubt und wir übernehmen und halten hier die Stellung. Wir haben gerade schon im Vorgespräch so ein bisschen gesagt, ich kränke so ein bisschen rum, ich hoffe die Stimme hält durch, klopfen wir auf Holz, ich klopfe gegen meinen Stirn, dass es nur am Kränkeln bleibt und nicht wirklich krank wird. und ja.

Elli:

Ja, ich bin auch ein bisschen matschig, aber ich habe das Gefühl, wir sind nicht alleine. Also ich habe das Gefühl, viele Menschen sind jetzt nach dem Januar und so in den ersten Zügen des Februars, also ein bisschen so, naja.

Caspar:

Ich fühle das sehr, aber ich kann auch sagen, und das ist mir jetzt neulich aufgefallen, die Sonne geht schon deutlich früher auf als die letzten Tage und wenn ich ins Büro fahre, fahre ich jetzt morgens schon im Hellen und das ist doch etwas, das ist doch schön, es geht aufwärts. So muss man das immer sehen.

Elli:

Das stimmt. Und es bleibt auch länger hell abends. Also wenn man irgendwie aus der Arbeit kommt, dann hat man vielleicht teilweise sogar noch nicht ganz tiefschwarz draußen. Das ist auch nicht schlecht, finde ich. Und so langsam der Frühling, ab und zu riecht es schon so nach Frühling. Finde ich gut.

Caspar:

Stimmt, das ist ja auch wärmer jetzt. Aber jetzt beschäftigen wir uns mit Tech News, tauchen ab in eine Sendung, die auch versprochenerweise, ja natürlich die Tech-Themen sind nicht immer ganz einfach aber nicht ganz so schwer ist, wie wir das in den letzten Wochen immer mal wieder hatten. Vor allem werden wir im Input mal schauen, ob mein, ich sag mal, technischer Lebenstraum bald in Erfüllung geht und die Geschirrspülmaschine nicht mehr von mir ausgeräumt werden muss. Aber da kommen wir dann zu.

Elli:

Wer schon ganz lang dabei ist, der erinnert sich an diesen Traum von Caspar.

Caspar:

Aber vorher gucken wir uns die Updates an und da sprechen wir unter anderem über einen kleinen Diss.

Elli:

Und zwar hat Anthropic, also ein KI-Hersteller, OpenAI, so ein bisschen gefoppt, sagen wir mal. Es war ja in der vergangenen Woche der Superbowl in Amerika. Caspar, du warst da involviert, du hast da mitgefiebert.

Caspar:

Was heißt involviert? Das klingt, wie wenn ich als eines dieser Strohbüschel auf dem Feld gestanden hätte bei der Halftime-Show. Aber ich habe mir tatsächlich den Tag Urlaub genommen und habe es mir angetan, das live anzugucken. Also ich war um 0.30 Uhr ging es los. Ich war bis viertel vor fünf, war ich wach, dann bin ich ins Bett. Morgens natürlich.

Elli:

Ich gehe gar nicht weiter auf den Superbowl ein, weil ehrlich gesagt, ich habe keine Ahnung von Football und ich möchte mich jetzt hier nicht irgendwie in eine unglimpfliche Situation reiten. Deswegen gucken wir direkt, wenn so ein großes Event ist, so ein Fernsehevent, dann gibt es ja auch immer Werbung und darum soll es gehen. Diese Werbeeinblendungen, die werden immer heiß diskutiert, Firmen denken sich da ganz große Dinge für aus. Und Antropic hatte einen Werbespot da gebucht.

Caspar:

Antropic, die Firma, die ihr vor allem auch hinter Eklord kennt, dem KI-Tool. Und in diesem Werbespot, ja, da gab es einen Slogan. Und zwar, es gibt eine Zeit und einen Ort für Werbung, aber ihre Unterhaltung mit KI sollte nicht dazu gehören. und dann sieht man auch entsprechend Werbung in diesen Chat-Geschichten. Dieser Spot ist ganz lustig anzugucken. Wir gucken mal, den gibt es sicherlich auch auf YouTube, den verlinken wir euch auch. Das Ganze zielt natürlich auf etwas Bestimmtes ab und wer sich ein bisschen in der Tech-Branche auskennt, weiß auch worauf. Wir haben hier auch drüber gesprochen, Elli. Was meint Anthropic damit?

Elli:

Es ist ziemlich offensichtlich. Antropic hat gegen OpenAI geschossen mit dieser Werbung. Denn OpenAI hat sich ja entschieden, mit Werbeeinblendungen bei ChatGPT zu experimentieren, weil man dann doch irgendwann so langsam mal Profit machen möchte aus der ganzen KI-Geschichte. Und Sam Altman, der Gründer von OpenAI oder einer der Mitgründer von OpenAI und jetzt CEO, hat sich lange gegen Werbeeinblendungen ausgesprochen und ist jetzt eben doch umgeschwenkt. Und wir bleiben noch bei Sam Altman. Der fand das Ganze natürlich weniger lustig, was Antropic da gemacht hat und diesen Werbespot. Er hat sich dann auch geäußert im Nachgang und betont, dass die Werbeintegration bei Chattipity auf gar keinen Fall so aussehen wird, wie von Antropic im Werbespot dargestellt. Und das sei ja alles überzogen. Und ja, er fand das nicht so die feine Art.

Caspar:

Ja, und Antropic hat in dem Werbespot selber aber auch nochmal klargestellt, bei uns wird es niemals Werbung geben. Also das hat mich so ein bisschen an so typische Werbeschlachten früher zwischen McDonalds und Burger King erinnert. Und es gab während des Superbowls tatsächlich auch noch eine zweite Werbung, die so ein bisschen in die Richtung ging. Da hat nämlich der Coca-Cola-Eisbär in einer Blindverkostung die Pepsi gewählt statt der Coca-Cola und hat eine kleine Lebenskrise bekommen, was übrigens ein KI-Spot war. Zwei Firmen haben da gegeneinander geschossen und in diesem Fall halt auch mal KI-Firmen.

Elli:

Yes, damit verlassen wir den Superbowl und gehen weiter. Wir bleiben nochmal bei KI und gucken uns einen Hack an, der passiert ist.

Caspar:

Genau, wir haben vergangene Woche ja über KI-Agenten gesprochen, genauer gesagt über Claudebot und wir haben da auch ganz kurz ein Thema angerissen, nämlich die Plattform Moldbook. Das ist so eine Art, ja, Social Media, ja, würde ich sagen.

Elli:

Forum, ja, Forum für KI-Ergenden.

Caspar:

Genau, die da unter sich, vor sich hin posten können. Leute, also echte Menschen können das zwar lesen, sind aber offiziell quasi nicht eingeladen, sondern die soll schon unter sich sein. Und das Ganze wurde ähnlich wie CloudBot, dieser eigentliche Bot, der vergangene Woche Thema war, auch durch Vibe-Coding gebaut. Also durch Code, der durch KI geschrieben ist. Und wir hatten ja bei CloudBot schon gesagt, das kann unter Umständen ein Sicherheitsrisiko sein. Und das war es jetzt offenbar auch bei Moldbook. Richtig.

Elli:

Ein Team des Security-Anbieters Wizz hat sich im Maltburg mal genauer angeschaut und da eine Sicherheitslücke identifiziert. Was konnten sie durch diese Sicherheitslücke rauskriegen? Mailadressen, die die User benutzt haben, Privatnachrichten, die sich die Agenten hin und her geschickt haben und auch API-Authentifizierungstoken, die benutzt wurden. Die WIS-Mitarbeitenden haben, also es gab dann einen Artikel quasi im Firmenblog von WIS und da schreiben die Mitarbeitenden auch, sie haben sich beim Team von Maltbook gemeldet und diese Lücke wurde innerhalb von wenigen Stunden geschlossen. Gleichzeitig macht das Ganze eben auch klar beim Vibe-Coding, also bei Software, die allein von KI geschrieben wird, da können ganz schön schwerwiegende Upsis einfach mal passieren. Jetzt muss man an der Stelle auch noch dazu sagen, WIS ist ein Security-Anbieter, das heißt, die haben da schon auch Interessen, auf solche Sicherheitslücken, hinzuweisen, ne, die sind, Es ist dann naheliegend zu sagen, jo, mit unseren Produkten passiert euch das natürlich nicht. Aber diesen Sicherheitsaspekt beim Vibe-Coding, den behalten wir doch direkt mal für unser What-the-Fuck im Hinterkopf.

Caspar:

Genau, da wird der nämlich wichtig. Wir nehmen mit KI und KI schreibt Programmcode kann gefährlich sein. Und damit ab ins WTF, wo wir uns mal wieder die beliebte Firma Meta angucken, die so ein bisschen diese Rubrik ja abonniert hat.

Jingles:

WTF.

Caspar:

Ja, wir haben hier im Podcast ja auch immer mal wieder das Thema KI und Arbeitswelt. Wir haben uns ja auch schon mal angeguckt, wie das auf den Jobmarkt, welche Auswirkungen das hat. Und jetzt wollen wir über einen Bericht von The Information sprechen. Das ist eine Plattform, die sich die Informationen über ein internes Meeting von Meta bekommen hat und darüber berichtet, was Meta jetzt beim Thema KI und Arbeitsmodell neu machen möchte.

Elli:

Genau, tatsächlich geht es nicht nur um ein Meeting, sondern auch um ein Memo, wo dann Sachen in die Firma gegeben wurden, quasi ins Team. Und wir erinnern uns, Meta baut immer wieder Stellen ab. Anfang des vergangenen Jahres hat der Konzern ganz sympathisch angekündigt, sogenannte Low-Performer zu entlassen. Und auch in der KI-Abteilung und in der Metaverse-Sparte haben sie zuletzt Personal abgebaut. Ja, und weil man eben die Performance im Team erhöhen möchte oder möglichst viel Performance da sehen möchte von den Mitarbeitern, gibt es jetzt, beziehungsweise im Laufe des Jahres soll das kommen, eine neue Art der Leistungsbewertung.

Caspar:

Genau. Und zwar ist die direkt an die Nutzung von künstlicher Intelligenz geknüpft. Dazu führt der US-Konzern ein neues KI-gestütztes Bewertungssystem ein für die Mitarbeitenden, also die Personen, die dort arbeiten, werden bewertet. Und Ziel ist es wohl, den Einsatz vom KI im Alltag systematisch zu fördern und messbar zu machen. Und da geht es vor allem unter anderem auch um die Entwicklung und das Coding. Also es geht tatsächlich um die Menschen, die eigentlich bisher händisch Code geschrieben haben. Und in dieser unternehmensweiten Versammlung, die wir eben angesprochen haben, informiert die Unternehmensführung die Belegschaft eben über ein neues Leistung- und Bonussystem, das eben mit diesem Bewertungssystem überprüft werden soll. Dafür hat die Firma ein neues Tool entwickelt und das heißt Checkpoint und das analysiert unter anderem, wie viele Codezeilen SoftwareentwicklerInnen mit Hilfe von KI erstellt haben.

Elli:

Also sind wir dann wieder beim Vibe-Coding.

Caspar:

Ganz genau. Insgesamt wertet Checkpoint rund 200 Datenpunkte aus. Darunter die Anzahl von Fehlern im Code. Da geht es jetzt nicht um Sicherheitslücken, sondern um sowas wie zum Beispiel Schreibfehler und ähnliche Dinge. Auch wie viel Code man geschrieben hat, beziehungsweise den die KI dann übernommen hat. Und jetzt leuchten vielleicht bei dem einen oder anderen schon Alarmglocken, weil man denkt, ui, ein Bewertungstool. Und da wird genau gemessen, wie viel man tut. Und vielleicht leuchten dann auch bei der Belegschaft die Alarmglocken auf, aber laut einem Personalleiter in diesem unternehmensweiten Meeting dient das Tool nicht als Aktivitätstrecker, das könnte man jetzt leicht in Anführungszeichen setzen, sondern lediglich als Instrument zur Erfassung der Wirksamkeit.

Elli:

Ja, insgesamt gibt es obendrauf noch ein überarbeitetes Bonussystem, wer besonders hoch bewertet wird in den vier Leistungskategorien, der kann einen Bonus von bis zu 200 Prozent erhalten und jetzt hattest du ja gerade gesagt, man möchte die Wirksamkeit von KI-Einsatz messen mit diesem neuen Tool. Der CEO Mark Zuckerberg, der hat da schon so gewisse Erwartungen, würde ich mal sagen. Also für den ist eigentlich schon relativ klar, was passieren soll.

Caspar:

Genau, der erhofft sich, beziehungsweise er glaubt fest daran, dass es Effizienzsteigerungen gibt. Es ist wohl so, dass Projekte, die früher große Teams erfordert haben bei Meta, die könnten laut dem Bericht jetzt bei Meta wohl von einzelnen hochqualifizierten Mitarbeitenden bearbeitet werden. Das wünscht man sich bei Meta. Ob das so hinhaut, weiß ich nicht. Das ist zumindest die Erwartung, die man an diese neuen KI-Tools hat.

Elli:

Genau, also Mark Zuckerberg hat das tatsächlich auch so gesagt, dass er erwartet, dass Aufgaben, wo früher ganze Teams dran gesessen haben, jetzt eben von einzelnen Leuten absolviert werden sollen. An der Stelle kurzer persönlicher Einschub. Wenn wir jetzt schreiben würden, würde man jetzt Kommentar dran schreiben. Das macht mich ein bisschen sauer, so ganz persönlich. Weil ich mir denke, okay, aber wenn wir dann nur noch einzelne Menschen sitzen haben, wer bringt denn dann denen, die danach kommen, was bei? Aber gut, das ist nicht die Sorge von Herrn Zuckerberg. Bisher, wir können auch mal gespannt bleiben. Ich habe ja so die leise Vermutung, wenn das nicht so ausfällt, wie man sich das wünscht, dann werden wir davon gar nicht mehr viel hören. Wie ist denn aktuell die Lage, Caspar, was so Effizienz durch KI angeht? Da gibt es ja schon ein paar Untersuchungen aktuell.

Caspar:

Genau, es gibt sogar mehrere Studien, die das inzwischen untersucht haben, unter anderem in Deutschland, aber auch weltweit. Und da ist es so, dass KI noch keine große Effizienzsteigerung gebracht hat. Unter anderem, weil man zum Beispiel Personal schulen muss, unter anderem, weil die Modelle noch gar nicht so weit sind und weil man sie vielleicht auch falsch einsetzt. Also gerade als der Hype so groß war beim Thema KI, ging es ja ganz oft darum, wir müssen jetzt irgendwas mit KI einbauen, ohne dass man sich groß Gedanken gemacht hat, ob das wirklich ein sinnvoller Einsatz ist. Eigentlich geht man ja von der anderen Seite her, man hat erst einen Use Case, guckt dann, wie man den lösen kann und dann könnte KI eine der Lösungen sein. Keine Wunderwaffe und das scheint bisher zumindest in der Wirtschaft noch nicht so große Gewinne oder Effizienzsteigerung zu bringen. Deswegen bleibe ich ein bisschen skeptisch, ob es wirklich hinbekommt bei Meta, dass da ganze Teams irgendwie eingespart werden. Aber weil wir ja auch eben das Update hatten mit dem Vibecoding, Meta hantiert halt doch mit sehr vielen personenbezogenen Daten und solche Dinge. Ich möchte nicht, dass das irgendwann doch mal durch den Hack rauskommt, weil sie so viele EntwicklerInnen eingespart haben, dass dann jemand mehr auf die Sicherheit drauf guckt.

Elli:

Ach, naja, also Sicherheitsproblematiken gab es ja jetzt auch schon mit menschlichen Teams.

Caspar:

Stimmt, stimmt.

Elli:

Aber, wer sind wir, darüber zu sprechen? Ich würde sagen, an der Stelle machen wir das What the Fuck einfach wieder zu. Ihr wisst jetzt ein bisschen, wo die Reise bei Meta hingehen soll und was da gerade so die Überlegungen sind, was man rausfinden möchte und was eigentlich auch die Absicht ist quasi. Und dann von Software, die was überwachten soll, gehen wir mit unserem Input mal wieder ein bisschen in den Bereich Hardware, was zum Anfassen.

Caspar:

Ja, aber auch so ein bisschen Science Fiction steckt da mit drin.

Elli:

Wir fangen an mit einer Personenbeschreibung und zwar geht es um Moya. Moya ist eine Frau, sie ist 1,65 groß, hat erdbeerblonde Haare und ein hübsches Gesicht, und sie nickt, sie interagiert, sie lächelt, sie läuft und ihre Haut ist weich und warm und, Die Idee ist, Moya soll in der Pflege und im Service aushelfen. Sie ist als soziale Begleiterin gedacht und emotionale Ansprechpartnerin. Und wer jetzt bei dem Satz, ihre Haut ist weich und warm, schon ins Stutzen kam, das würde ich ja bei einer normalen Menschenbeschreibung definitiv nicht dazu sagen.

Caspar:

Es wäre zumindest komisch.

Elli:

Der hat sich vielleicht schon das Richtige gedacht. Moya ist ein Roboter. Und sie soll laut Firmenangaben, in dem, wie sie mit anderen Menschen interagiert, zu 92 Prozent Menschen ähnlich sein. Wer sich jetzt Videos von Moya anschaut im Internet, es gibt so ein Zwei, der merkt schnell, also diese 92 Prozent, die sind schon sehr optimistisch.

Caspar:

Ist die Frage für wen? Also wenn jemand blind taub ist, dann vielleicht. Also weil du hast sie gerade so beschrieben und jetzt hat man das Bild irgendwie vor Augen, wirklich so eine hübsche weibliche Person. Ich weiß auch nicht, was ist eigentlich Erdbeerblond? Das wäre nochmal eine spannende Frage.

Elli:

Erdbeer Blond ist so ein helles Blond, wo dann so rosa rein gefärbt wird oder so ein bisschen rosa-rot.

Caspar:

Ja, jetzt habe ich das vor Augen.

Elli:

Diese Mischung, die heißt Strawberry Blond tatsächlich.

Caspar:

Ja, jetzt habe ich das vor Augen. Aber wenn man dann Moya tatsächlich mal sieht, merkt man sofort, das ist ein Roboter. Das ist kein Mensch und menschenähnlich. Gut, jetzt habe ich noch nicht viel mit Moya agiert und interagiert, weiß ich jetzt nicht. Vielleicht wäre ich ja positiv überrascht, aber du hast ja auch, glaube ich, ein Video davon. Vielleicht können wir das dann auch in den Shownotes verblinken. Da sieht man Moya dann auch mal. Ich finde es nicht so richtig menschenähnlich.

Elli:

Und spätestens, wenn man noch ein, zwei Infos dazu gepackt hätte, nämlich zum Beispiel, dass Moya ganze 32 Kilo wiegt, hätte man sich denken können, ah, das ist vielleicht kein 1,65 Meter großer Mensch. Warum sprechen wir über Moya? Moya ist ... Anfang dieser Woche vorgestellt worden in China von einer Robotikfirma. Und laut Berechnungen der Investmentbank Morgan Stanley haben chinesische Städte wie Beijing und Shenzhen seit 2024 mehr als 26 Milliarden Dollar in entsprechende Hersteller gepumpt. Also in die Herstellung von humanoiden, menschenähnlichen Robotern. Und deswegen dachten wir uns, wir gucken da heute mal drauf. In China soll das also irgendwie so der wirtschaftliche und technologische nächste Hit werden. Aber was ist dran an dem Ganzen? Wozu brauchen wir das? Wo sind wir gerade? Das schauen wir uns heute einfach mal an.

Caspar:

Und auch, wie sieht es vielleicht im Rest der Welt aus in anderen Ländern? Lass uns mal in China bleiben. Du hast gerade schon gesagt, da liegt so ein bisschen der Fokus drauf. Das erinnert mich sogar leicht an die Elektromobilität. Da ist China ja auch ganz stark dabei und investiert ganz viel und es wird auch staatlich ganz stark gefördert. Das ist jetzt so ein weiterer Markt, in dem China wirklich an die Spitze kommen möchte. Der Fokus liegt eben ganz besonders auf diesen menschenähnlichen Robotern. Auch wer auf der IBC war oder Videos davon gesehen hat, da waren ganz viele chinesische Hersteller, die ebenso menschenähnliche Roboter vorgestellt haben. Und laut einer Recherche des Wall Street Journals will China in den nächsten fünf Jahren zum globalen Marktführer werden, was eben diese Art von Roboter angeht. Und fünf Jahre sind in der Tech-Welt jetzt gar nicht mehr so lange hin. Nein.

Elli:

Quasi ein Wimpernschlag in der Tech-Welt. Ja, tatsächlich, die Voraussetzungen sind dafür auch gar nicht schlecht. Zumindest, wenn man mal in den Bereich Hardware anguckt, weil viele Teile, die auch international in Robotern verbaut werden, kommen aus China. Also zum Beispiel Sensoren, Batterien, Motoren, all sowas wird in China gefertigt und man sitzt also quasi an der Quelle. Das macht das Ganze relativ günstig für chinesische Unternehmen. Jetzt geht es aber um Optimierung in zwei Bereichen. Zum einen diese Hardware-Bereiche. Die man dann zusammenbauen kann. Die Gesamtkonzepte, da ist noch Optimierungsbedarf. Also aktuell, wenn man in den Bereich humanoide Roboter geht, dann sind da Schwierigkeiten beim Laufen. Aber auch so was wie Hände ist noch eine schwierige Angelegenheit. Wie gestaltet man die, dass da genau die richtige Kraft drauf ist, dass da auch vielleicht Gefühl mit drin ist und so weiter. Dann haben sie jetzt bei Moya eben, Die Moya hat warme Latexhaut und eingebaute Gewebeimitate und auch einen nachgebauten Brustkorb. Also das sind jetzt mal Aspekte, auf die man sich da fokussiert hat. Es gibt noch einiges zu tun bei der Entwicklung von so humanoiden Robotern als Hardware allein. Und dann ist da noch die Softwarekomponente.

Caspar:

Genau, weil die ist nicht weniger wichtig, wenn sich der Roboter zwar gut bewegen kann, aber quasi kein Gehirn hat und nicht weiß, wo er hin soll, dann passieren ganz schlimme Dinge, das Ding kippt um, macht Sachen kaputt. Das ist nicht das, was man möchte, vor allem nicht, wenn so ein Roboter ja zum Beispiel mal in Pflegeheime einziehen soll, wie Moya oder in Haushalte. Und natürlich, Überraschung, könnte auch das Thema KI ein ganz wichtiger Punkt sein, um dieses Software-Thema anzugehen und da vor allem auch endlich mal zum Durchbruch zu führen. Denn Hardware-technisch sind wir, wir werden auch gleich nochmal auf Boston Dynamics zum Beispiel gucken, eine Firma in den USA schon relativ weit. Software ist aber ein großes Thema. Bei KI ist es aber so, bisher gibt es KI-Anwendungen, die auf gewisse Dinge spezialisiert sind. Ihr wisst es ja selbst, Sprachmodelle, mit denen man chatten kann, Bildmodelle, mit denen man Bilder generieren kann. Es gibt Schachcomputer, die speziell für Schachspielen gedacht sind und solche Dinge. Aber Unternehmen wie OpenAI, Entropic, Google und Co., die arbeiten daran, dass diese KI-Modelle und KI-Bots immer mehr universell werden und auch immer mehr universelle Fähigkeiten bekommen. Und da kommen wir dann in einen Bereich, der für humanoide Roboter sehr wichtig werden könnte.

Elli:

Diese... Alle allumfassenderen KI-Modelle, die jetzt eben gebaut werden, die wiederum führen zu einem Aufschwung beim Thema Robotik. Denn die Idee ist, zu so einem Chatbot zum Beispiel, der zu allen möglichen Themen seinen Senf dazugeben kann, könnte man ja jetzt auch eine Hülle bauen quasi. Deswegen wird im Zusammenhang mit humanoiden Robotern teilweise auch von Physical AI gesprochen. Das Spannende ist, diese Roboter sollen eben durch entsprechende KI-Software immer mehr in der Lage zu sein, selbstständig auch auf ihre Umgebung zu reagieren und Vorgänge zu beobachten und eigenständig zu lernen.

Caspar:

Ja, und China, wie gesagt, möchte auch, das möchte auch die politische Kaste in China, möchte man jetzt dieses Thema voranbringen und dazu gibt es ein paar Fördervarianten quasi, die man sich ausgedacht hat, wie man auf Platz 1 kommt. Das eine ist nicht nur, dass man quasi Geld obendrauf wirft auf diese Firmen, die es dort gibt, sondern man bietet zum Beispiel auch vergünstigte Büroflächen und man subventioniert Uni-Absolventinnen, die quasi frisch von den Unis ausgebildet dann in diese Firmen reinkommen und dort arbeiten können.

Elli:

Was ich außerdem ganz spannend fand, chinesische Behörden werden auch direkt zum Kunden. Also man findet in China zum Beispiel humanoide Roboter in Museen oder bei der Verkehrsüberwachung und damit wird das ganze Thema natürlich auch einfach für den Alltag präsenter, also auch für die große Masse irgendwie sichtbar und man kommt schon mal so ein bisschen damit in Berührung.

Caspar:

Jetzt könnte man denken, wir reden hier ganz viel von China, wir reden davon, dass es auch in den USA diese Entwicklung gibt. Mein Gott, das sind vielleicht schon tausende Firmen, die diese Roboter herstellen. Nee, so groß ist der Markt noch gar nicht, so viele Firmen sind das auch gar nicht. Laut einer Schätzung des McKinsey-Analytikers Christian Janssen gibt es ungefähr aktuell rund 100 Firmen nur, die sich mit dieser Robotik-Geschichte auseinandersetzen. Und er schätzt auch, in Deutschland ist das ein rundes Dutzend an Unternehmen, also wirklich überschaubar, die sich mit Robotik und auch eben mit Physical AI auseinandersetzen.

Elli:

Und da muss man dann auch nochmal unterscheiden, weil dieses ein Dutzend Unternehmen, die er jetzt in den Ring geworfen hat, das sind so Robotics, Physical, AI insgesamt. Wenn es dann um humanoide Roboter geht, wird das Feld nochmal kleiner. Wir haben hier mal drei mitgebracht. Einmal Neura Robotics, die sind in Metzingen, gibt seit 2019 Metzingen, falls jemand kritisiert. Gar keinen Plan hat, wo das ist. Bade-Würdebech. Und dann gibt es Agile Robots. Die sind in München. Die gibt es seit 2018.

Caspar:

Da sind wir dran vorbeigelaufen. Erinnerst du dich? Ich glaube, das war deren Büro. Kann das sein? Wir sind an irgendeinem Robotik-Unternehmen vorbeigelaufen. Da standen auch die Roboterarme im Schaufenster quasi. Das war da, wo die Stühle hochgeklappt waren, damit der Staubsaugeroboter überall drunter durchkam.

Elli:

Ja, ja, ja. Stimmt. Es war nachts in München. Ich erinnere mich. Ja. Ja, genau. Und jetzt gucken wir mal ganz kurz, wie da die Lage ist bei denen. Bei Agile Robots will man, so steht es zumindest auf der Webseite, Anfang 2026 mit der Produktion von Agile One starten. Das ist ein humanoider Roboter, der für den Industriekontext gedacht ist. Und bei Neurorobotics, da können Interessierte momentan den, Achtung, jetzt wird es hässlich, 4 NE1 bestellen. Also vorreservieren zumindest. Und es gibt auch noch eine Kompaktversion, den 4NE1 Mini. Erscheinen sollen die beiden Roboter im April. Mal gucken, was das wird. Und ich hatte ja vorhin von drei Namen gesprochen. Wir werfen noch einen dritten deutschen Akteur in den Ring. Der ist aber nicht einfach mit dem Ziel Robotics gestartet, sondern das ist der Industriezulieferer Schäffler. Der sitzt in Herzogenaurach.

Elli:

Und fand ich ganz spannend, weil auch da konzentriert man sich jetzt unter anderem auf Roboter. Und da gibt es den Roboter Digit. Ein kleiner Unterschied zu Neurobotics und Agile One ist da so ein bisschen die Optik. Also Digit, der hat schon so Augen quasi, die so ein bisschen blinzeln können und sowas auch. Aber von der Figur her ist das deutlich mehr noch, wie man sich so einen kleinen Versuchsroboter quasi vorstellt. Auch wenn er nicht klein ist.

Elli:

NeuroRobotics und Agile One haben dann schon noch mehr die menschlichen Körperformen nachgeahmt quasi. Also da sehen die Roboter ein bisschen athletischer aus. Zumindest auf den Bildern, die es jetzt gibt.

Caspar:

Bei Herzogenaurach habe ich gerade aufgehorcht, Weil das ist übrigens auch der Hauptsitz von Adidas ist in Herzogenauroch. Also ein kleiner Industrie-Hotspot da. Ich glaube in Franken ist das.

Elli:

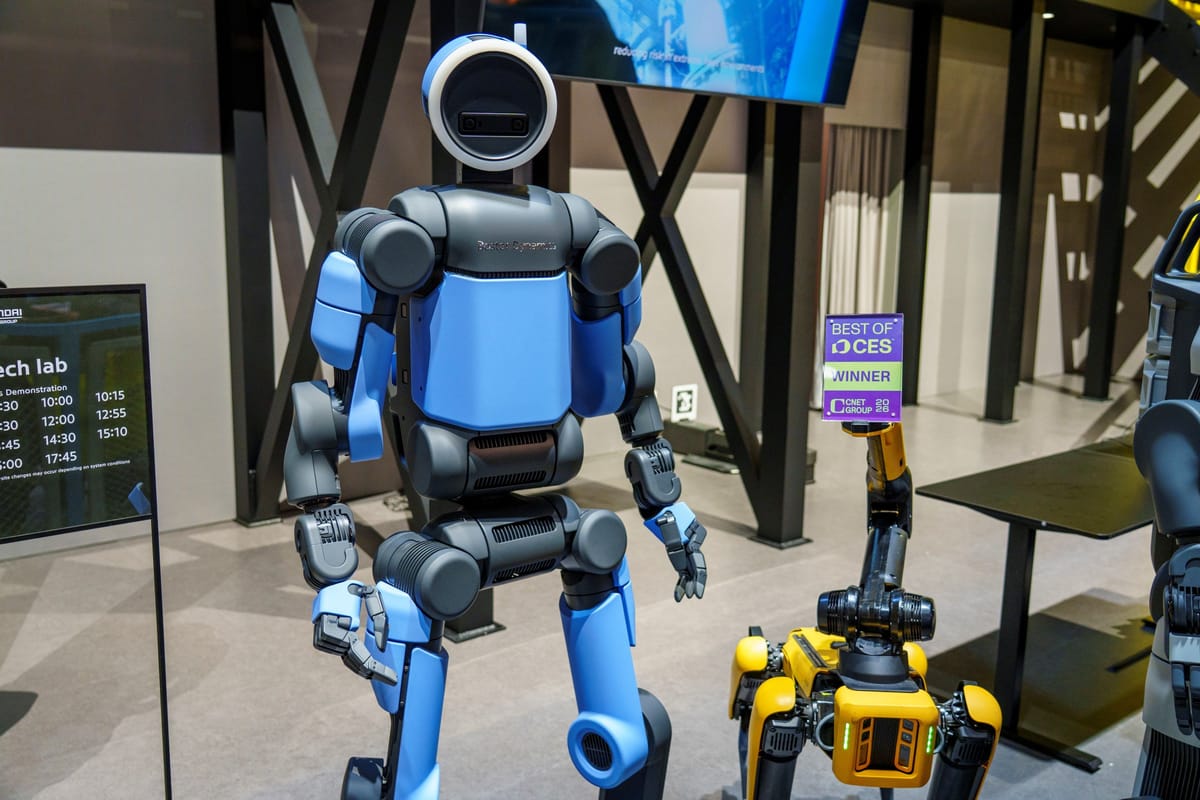

Also wenn es um Roboter in Deutschland geht, dann könntet ihr euch die Namen neurer Robotics, Agile One und Schäffler mal merken. Wir gucken jetzt aber nochmal, wir kamen ja aus China, sind jetzt kurz in Deutschland gewesen, jetzt gucken wir nochmal in die USA, denn da ist mit einer der größten Konkurrenten für chinesische Firmen wahrscheinlich Boston Dynamics. Und Boston Dynamics ist besonders spannend, weil ihr habt ja jetzt gehört, Agile One und Neuro Robotics 2011. 2018 und 2019. Boston Dynamics hat schon ein bisschen mehr Geschichte.

Caspar:

Ja, ja doch. Auch deutlich älter als die Firmen, die in China unterwegs sind in der Regel. Denn Boston Dynamics gibt es schon seit 1992. Da wurde die Firma als Ausgründung des Massachusetts Institute of Technology, besser bekannt auch als MIT, gegründet. Das heißt, da haben wirklich Wissenschaftlerinnen und Wissenschaftler, die hochspezialisiert sind, diese Firma mitgegründet. Zwischenzeitlich gehörte Boston Dynamics zu Google bzw. zu der Mutter Alphabet von Google und seit 2021 besitzt Hyundai, ja, das sind die mit den Autos, 80 Prozent des Unternehmens.

Elli:

So, also wir haben jetzt gehört, die gibt schon was länger. Wir gucken aber jetzt mal auf die Gegenwart und im Januar hat die Firma ihre Pläne für die nahe Zukunft vorgestellt und da ging es auch um einen humanoiden Roboter.

Caspar:

Ganz genau. Die sind nicht ganz so, naja, wobei doch, sie sind ähnlich ambitioniert wie in China. Das Ganze soll auch so in den nächsten fünf Jahren, fünf, sechs Jahren passieren. Und zwar geht es um den Roboter Atlas. Das ist auch ein humanoides Modell. Die erste Generation, die gibt es schon seit 2013. Das war wirklich noch, wenn man sich Bilder anguckt, wenn ihr das mal in den Wikipedia-Artikel von Atlas aufruft, seht ihr da zum Beispiel die erste Generation. Eigentlich beschreibt man das am ehesten als klobiges Metallgestell mit ganz vielen Kabeln, Schläuchen, Drähten. Der war auch noch an der Decke befestigt, wenn er läuft, damit er nicht umkippt. Der wog 150 Kilo und lief sehr, sehr wackelig irgendwie durch die Gegend. Dann gab es zwischendrin eine verbesserte Version, die teilweise schon am Ende dann Parcours absolvieren konnte. Also diese großen Sprünge und Überhäuserdächer und sowas. Also das war schon relativ beeindruckend. Und da gibt es auch ein sehr gemeines Video, wo jemand mit einem Baseballschläger immer versucht, dem die Beine wegzuziehen. Wenn ich dieses Video sehe, denke ich mir immer, wenn die KI irgendwann mal übernimmt. Das wird eines der Beweisvideos, um zu erklären, warum er die Menschheit ausrotten möchte.

Caspar:

Das war die Geschichte von Atlas. Die aktuelle Modellversion, die ist 2024 vorgestellt worden. Das ist auch die, die jetzt quasi in Serie gehen soll. Da bleiben wir nochmal wieder bei der Beschreibung, die wir eben schon hatten mit Moya. Der neue Atlas ist 1,90 Meter groß, setzt nicht mehr auf Hydraulik wie die Vorgänger, sondern ist komplett elektrisch, ähnlich wie die Modelle aus China und wiegt nur noch 90 Kilo. Moya, wie gesagt, wog ja ungefähr ein Drittel.

Elli:

Man muss aber auch sagen, Moya ist ein bisschen kleiner mit 1,65. Aber ja, 90 Kilo versus 32 Kilo bei Moya, da liegt schon einiges dazwischen. Vielleicht liegt das aber auch so ein bisschen an dem, was Atlas können soll. Im Gegensatz zu Moya, wir erinnern uns, die ist ja so ein bisschen auf Companionship, also Begleitung und so Service und Pflege und sowas ausgerichtet. Atlas, der muss anders ran.

Caspar:

Ja, Atlas soll in die Fabrik und in den technischen Daten steht dafür, dass Atlas zum Beispiel bis zu 60 Kilogramm hochheben können soll. Also mehr als die Hälfte seines Körpergewichts, das ist schon relativ beeindruckend. Vier Stunden soll dieser Roboter mit einer Akkuladung durchhalten und er soll bei minus 20 bis plus 40 Grad einsatzfähig sein. Das ist auch eine ziemliche Spanne. Und er kann Bewegungen ausführen. Und auch das, wenn man sich mal Videos von Atlas anguckt, ist manchmal ein bisschen gruselig, weil er zum Beispiel den Kopf um 360 Grad drehen kann und auch den ganzen Tor so und auch quasi gefühlt rückwärts laufen kann. Und wie er aufsteht, sieht auch ganz seltsam aus. Also das Ding kann Bewegungen, die kein Mensch durchführen kann. Also so ein bisschen über das Humanoide hinausgeht.

Elli:

Vielleicht habt ihr, wie ich, bei der Akkulaufzeit ein bisschen aufgehorcht, denn vier Stunden mit einer Akkuladung, das ist für die aktuelle Robotik relativ gut, also vier Stunden, das ist schon was, aber an sich, wenn wir jetzt überlegen, vier Stunden eines Arbeitstages ist nicht besonders lang, also auch hier gibt es an sich noch Luft nach oben. Und wir hatten ja vorher über Hardware und Software gesprochen. Jetzt ist die Frage, was ist das Gehirn von Atlas quasi? Da wird tatsächlich zusammengearbeitet mit Google DeepMind. Wir kennen Google noch vielleicht von KI-Modell Gemini und da gibt es eben auch Gemini Robotics, also die Roboter-Version des Ganzen. Und wir haben vorhin schon drüber gesprochen, da ist eben genau diese Absicht, mit Gemini Robotics soll Atlas Aufgaben robuster und schneller lernen quasi, als dass man sie ihm wie bisher klassisch eben sehr genau vorgibt. In dieser und jener Umgebung machst du das und das.

Caspar:

Auch Boston Dynamics hat einen Zeitplan, ähnlich wie die Firmen in China. Noch 2026 soll es die finale kommerzielle Version des Roboters geben. Bisher waren das alles noch Prototypen und die soll, vorgestellt wurde sie schon, aber die hat sich zum Beispiel noch nicht bewegen können. Die kommerzielle Version soll dann auch in Produktion gehen und es soll erste Feldtests mit den Robotern geben. Für 2026 seien zum Beispiel Tests bei Hyundai angedacht in der Fabrik, so wie bei Google DeepMind. Dort soll es dann tatsächlich erste Pilotprojekte geben und soll in diesen Partnerumgehungen entsprechend arbeiten. Wirklich losgehen soll es dann 2028, da will man dann anfangen mit der Massenproduktion und Boston Dynamics spricht davon, dass sie bis zu 30.000 Roboter im Jahr herstellen wollen oder könnten. Das ist natürlich die Wunschzahl, so viel wird es wahrscheinlich am Anfang nicht sein und auch vor allem noch nicht 2028, aber man will dann wie gesagt mit der Serienproduktion oder der Massenproduktion loslegen und ab dann könnte es auch mal in die Fabriken gehen.

Elli:

Apropos Fabrik. Caspar, was soll denn Atlas da jetzt eigentlich machen?

Caspar:

Ja, auch 2028 geht es dann in einem echten Hyundai-Werk los, nämlich in Georgia und wirklich mit einem Arbeitseinsatz. Dort soll Atlas zunächst Teile sortieren, bereitstellen und in Reihenfolge bringen. Also ganz vereinfacht ausgedrückt, es gibt einen großen Salat mit ganz vielen Bauteilen, Atlas läuft los, sortiert ihn in die entsprechenden unterschiedlichen Baugruppen und bringt das noch in die Reihenfolge und fängt quasi an die Vorarbeit zu leisten, die für so eine Autoproduktion dann wichtig wäre.

Elli:

Also ihr seht schon, Boston Dynamics hat einen relativ konservativen Zeitplan. Es könnte tatsächlich so halbwegs realistisch sein, was sie sich da überlegt haben, während China Marktführer in fünf Jahren werden möchte. Wir sind da ja in ganz unterschiedlichen Schritten so ein bisschen.

Elli:

Jetzt frage ich mich aber natürlich, und das habe ich schon während der ganzen Recherche gefragt, wozu das Ganze? Wofür brauchen wir diese Roboter? Wir haben ja an sich schon Robotik in der Industrie, in der Logistik und so weiter. Da kommen schon Robotikvorrichtungen zum Einsatz. Aber dieses Humanoide, also Roboter, die wie Menschen agieren sollen. Warum das Ganze? Wir haben gehört, Laufen ist irgendwie schwierig. Dann fallen die hin, dann sind die Hände schwierig. Dann ist das mit der Mimik auch alles noch nicht so ausgereift.

Elli:

Wozu also der ganze Bums? Tatsächlich hat es auch, während ich recherchiert habe, relativ immer lang gedauert, bis diese Frage zum Beispiel in Artikeln beantwortet wurde oder überhaupt aufkam. Aber wir haben am Ende ein bisschen was für dieses Skript zusammenbekommen. Zunächst mal gucken wir uns nochmal an, wofür werden die Roboter denn ausgewiesen? Und Gaspar, du hast ja ganz am Anfang gesagt so, ja, also jemand, der mir den Haushalt macht, da würde ich sagen, da wärst du mit Moya besser bedient, also die Roboter-Dame vom Anfang, weil, wie gesagt, hier haben wir in erster Linie nicht harte, schwere körperliche Arbeit als Fokus, sondern eben empathische Begleitung, Companionship. Vielleicht könnte die dann auch leichtere Arbeiten machen. Ich finde es auch ein bisschen spannend, dass dieser Companionship auf der einen Seite so angepriesen wird und auf der anderen Seite eben aber Pflege. Also was ja auch eine sehr harte körperliche Arbeit ist.

Caspar:

Zum Beispiel feine Fingerspitzengefühl ihr auch braucht. Also wenn ich an Pflege denke, das kannst du auch nicht mit Haut drauf und Hauruck manchmal machen. Also ja, ich bin gespannt, wie Moya das hinkriegen wird oder was die chinesischen Hersteller da entwickeln in nächster Zeit.

Elli:

Ja, also damit wärst du zumindest schon mal besser dran als mit so einem Atlas, der ja wirklich sehr auf die Industrie ausgerichtet ist. Bei Moya, wie gesagt, hat man dann ja auch den großen Wert draufgelegt, dass zum Beispiel die Gesichtsausdrücke irgendwie mit drin sind, die Hauttemperatur, das Gewebe und so weiter. Ich glaube aber, also bei Moya jetzt spezifisch, da könnte es wohl noch an deinem Geldbeutel scheitern.

Caspar:

Ja, weil was wir bisher noch verschwiegen haben, ist das Preisschild. So ein Roboter wie Moya kostet aktuell so um die 125.000 Euro. Es ist nicht günstig. Jetzt könnte man natürlich sagen, zum Marktstart 2026 kostet das so viel. Das wird vielleicht mal irgendwann günstiger. Ja, aber jetzt zum Marktstart heißt das, dass das nicht mal eben... Nebenan in der Küche stehen wird und für mich Sachen zubereitet oder im Restaurant auftaucht oder halt eben in einem durchschnittlichen Pflegeheim verwendet wird.

Elli:

Richtig, was man auch dazu sagen muss, also wir sind eben bei einem absoluten Luxusprodukt und diese 125.000 Euro, die sind ja nur die Anschaffungskosten. Da kommt ja dann auch noch Wartung dazu, da müssen vielleicht noch Ersatzteile irgendwann mal, Verschleiß ist auch so eine Thematik bei Robotern. Also das ist ein sehr teurer Spaß. Die Roboter, die zum Beispiel in Deutschland oder in den USA geplant werden, die sind mehrheitlich auf Logistik und Industrie ausgerichtet. Aber auch da haben wir aktuell noch das Problem, in Anführungszeichen, dass das finanziell noch nicht ausgereift ist, sagen wir es mal so. Aber wir haben zwei Punkte eben, die spannend sind. Und das eine ist so auf die Zukunft gerechnet. Ein Roboter, der gebaut ist wie ein Mensch, kann theoretisch, soll irgendwann in Umgebungen agieren können, die auch ursprünglich für Menschen gebaut wurden. Das heißt, ein Unternehmen muss, wenn es mit Robotik arbeiten möchte, dann nicht mehr irgendwie groß umbauen. Und das wiederum ist so ein Knackpunkt, der könnte ganz interessant sein.

Caspar:

Auch wenn man an Umgebungen denkt, die Menschen vielleicht aktuell betreten können, aber die schwieriger sind. Zum Beispiel, wir hatten jetzt gerade darüber gesprochen, dass Atlas minus 20 Grad ab kann. Ich weiß jetzt nicht, was in einem typischen Kühlhaus an Temperaturen herrscht, aber das geht wahrscheinlich so um die 20 Grad minus, wahrscheinlich ein bisschen weniger. Da könnte man zum Beispiel so einen Atlas einsetzen, der bräuchte nicht die ganze Zeit eine Winterjacke und müsste nach zehn Minuten noch wieder raus, weil er sonst erfriert. Das wäre zum Beispiel so ein Einsatzgebiet oder das, wo Boston Dynamic bisher auch schon sehr viel verkauft, nämlich ihren Roboterhund, den sie auch schon seit einer Weile anbieten und der tatsächlich auch schon verfügbar ist, kommerziell auch, der wird zum Beispiel von Feuerwehren eingesetzt in Katastrophengebieten oder in einschlitzgefährdeten Gebäuden, um halt mal reinzugucken, was da irgendwie los ist. Wenn dem der Himmel auf den Kopf fällt, beziehungsweise das Dach, dann ist das nicht so schlimm, wie wenn das einem echten Feuerwehrmann passiert oder einer Feuerwehrfrau.

Elli:

Das ist also Aspekt Nummer eins. Und Aspekt Nummer zwei ist tatsächlich die Interaktion mit Menschen, weil man tatsächlich so ein bisschen überlegt. Also da können wir nochmal auf Moya gucken, als Begleitung eben. Studien zeigen, wir Menschen attestieren Robotern, die menschenähnliche Features aufweisen, also Augen, Sprache und so weiter, wahrscheinlicher menschenähnliche Eigenschaften. Also ist vielleicht auch so ein bisschen die Überlegung, wir könnten uns mit menschenähnlichen Robotern im Zweifel besser anfreunden und ihnen auch so ein bisschen vertrauen. Zum Beispiel in der Pflege kann das ja ein Aspekt sein, dass man sich da einfach mehr wohlfühlt. Spannende dabei ist aber, zu realistisch dürfen die Roboter dann auch wieder nicht sein, zumindest nach aktuellem Stand nicht. Das ist der sogenannte Uncanny Valley Effekt. Wenn so ein Roboter dann zu menschlich ist, dann finden wir den nämlich wieder gruselig.

Caspar:

Ich meine, ich habe eben schon bei warmer Latexhaut kurz ein bisschen gedacht, na, ob ich das möchte, weiß ich nicht. Das geht ja in diese Richtung.

Elli:

Ja, ich kann an der Stelle nochmal einschieben. Dazu habe ich natürlich jetzt nichts gefunden, aber es ist ein Gedanke, der sich, Achtung, wir sind jetzt wieder bei Meinung, aus meiner Sicht durchaus aufdrängt, wenn wir von Companionship und von einer, äh, weiblichen Roboter-Dame mit warmer Latexhaut und so weiter sprechen, dann tun sich da auch in der Erwachsenenunterhaltung glaube ich Nischen auf. Und tatsächlich sagt man ja auch immer gerne bei Technologien, wenn es die Erotikbranche erreicht hat, dann ist es schon mal ganz spannend zu beobachten. Also mal gucken. Das ist natürlich auch ein Weg, der gerade wenn man dann, also wir sind ja bei einem Luxusprodukt, auch das dass ein Markt, bei dem sehr, sehr viel Geld unterwegs ist.

Caspar:

Ja, und auch die Frage, will man das? Aber das ist wieder eine andere Frage. Lass uns wieder zu den normalen humanoiden Robotern zurückkehren.

Elli:

Und zwar, was ich da noch ganz spannend finde, was wir jetzt kurz vor unserem Fazit auch noch einbinden, ganz oft denken so Firmen, die humanoide Roboter entwickeln, direkt in ganzen Ökosystemen. Also wir sind jetzt wieder in der Produktion, in der Industrie. Und da ist eben die Idee, man liefert am Ende nicht nur den humanoiden Roboter, der dann durch die Hallen laufen kann und sich eben auch dort bewegen kann, wo einfach, Gegebenheiten für Menschen zugeschnitten sind. Das Spannende ist dann aber eben, dass dieser Roboter zusätzlich direkt mit einer Softwareplattform verbunden ist und alle Informationen, die er quasi auf seiner Tour und bei seiner Arbeit sammelt, direkt in diese Softwareplattform fließen und auch mit allen anderen Geräten geteilt werden können. Also wo wir als menschliche Belegschaft im Zweifel noch irgendwo Eingaben machen müssen, irgendwelche Notizen machen müssen, irgendwelche Dokumentationen, da kann so ein Roboter, der seine Umgebung wahrnimmt, direkt alles schon mal weitergeben. Also auch das könnte noch spannend werden.

Elli:

Aber Stichwort könnte. Wir kommen zum Fazit. China möchte an die Spitze und das schon in den nächsten Jahren insgesamt, kann man aber sagen, auch wenn in China Robotik-Events stattfinden, sowas wie ein Roboter-Halbmarathon und so weiter und die Bevölkerung da schon mal dran gewöhnt wird an entsprechende Maschinen, Im Rest der Welt liegt der Fokus noch auf industriellen Einsätzen und bis humanoide Roboter wirklich in der breiten Masse einsatzfähig sind, ist noch einiges an Arbeit notwendig und auch die Kosten müssen sich noch ein bisschen verändern.

Caspar:

Ob wir dann wirklich 2030, wir werden es natürlich für euch im Blick behalten, dann soweit sind, dass in den USA in Firmen oder bei Hyundai in Firmen dann die Roboter eingesetzt werden und in China dann tatsächlich in der Pflege schon, ich wage es fast zu bezweifeln. Dieser Markt ist generell ja auch, und da blicke ich einmal noch ganz kurz auf Tesla und Elon Musk, ein Markt, der sehr oft sehr viele Versprechungen macht. Das ist auch bei anderen Robotikfirmen oft so gewesen. Wir erinnern da an den Bot, den Tesla vorgestellt hat, vor, ich glaube, inzwischen anderthalb, zwei Jahren oder vor einem Jahr. Also es ist so gewesen, dass auch Tesla einen Roboter entwickelt. Da waren es Menschen in irgendwelchen Strampelanzügen lange Zeit, weil die Entwicklung überhaupt noch nicht so weit vorangestritten war. Und da wollte man eigentlich auch schon ganz lange, ganz viele tolle Dinge damit machen, stellt sich raus, bisher ist das noch nicht der Fall gewesen. Das heißt, bis ich dann mal wirklich meinen Roboter in der Küche habe, der für mich den Geschirrspüler ausräumt. Ich glaube, auch 2030 wird das noch nichts.

Elli:

Ja, muss ich ehrlich sagen, ich denke das auch nicht. Aber wenn man aus der heutigen Folge eine Sache mitnehmen kann, finde ich, dann ist das dieser Aspekt, Software, Hardware. Wenn ihr in Zukunft über Weiterentwicklungen im KI-Bereich was hört, dann könnt ihr immer so im Hinterkopf behalten, dass das auch für die Robotik interessant sein könnte. Gerade wenn es darum geht, dass KI eben sich selbst in Anführungszeichen Dinge beibringt, die Umgebung wahrnimmt und so universeller wird. Weil, wie gesagt, das ist für die Robotik und für entsprechende Weiterentwicklungen sehr, sehr spannend, wenn dann die Hardware auch mal entsprechend mitkommt.

Caspar:

Und das Zusammenspiel funktioniert. Aber wie gesagt, wir behalten es im Blick. Und wenn ich hier bei mir einen Roboter habe, dann laden wir ihn mal in den Podcast ein.

Elli:

Jetzt hatten wir den Input zum Thema Hardware. Wir gehen jetzt noch mal für die Good News in den Softwarebereich und es wird gespielt. Ach, schön.

Caspar:

Brettspiele beziehungsweise, ne Brettspiele nicht, Gesellschaftsspiele.

Jingles:

Gute Nachricht.

Caspar:

Ja, wer jetzt aber ein Siedler von Katan oder Mensch ärgere dich nicht denkt, den müssen wir leider enttäuschen. Es geht um ein sehr, sehr, sehr, sehr, sehr viel älteres Spiel.

Elli:

1500 Jahre bis 1700 Jahre alt. Caspar, wer gräbt denn solche Sachen aus?

Caspar:

Ja, in dem Fall war das Walter Christ, der ist Experte für Antike Spiele, beschäftigt sich also ganz viel damit und du hast gerade Ausgraben gesagt, jetzt könnte man denken, er hat irgendwie an einer archäologischen Ausgrabung teilgenommen, hat das da entdeckt. Nee, so war es nicht. Er hat tatsächlich ein Museum besucht, genauer gesagt ein Museum in den Niederlanden, in der niederländischen Stadt Herlen. Und das ist ein Museum über eine römische Therme, die dort damals stand. Dort gab es nämlich die römische Siedlung Coriovalum und die hatte dann eben, wie gesagt, eine Therme. Und in diesem Museum ist er durch die Ausstellung gelaufen und ihm ist plötzlich ein Stein aufgefallen. Ein Stein, der ihn an etwas erinnert als Spiele-Experte.

Elli:

Aber dann doch wieder Ausgrabung, oder? Zumindest der Stein muss ja irgendwann ausgegraben worden sein.

Caspar:

Ja, genau. Allerdings ist das schon eine Weile her, nämlich im späten 19. Jahrhundert oder im frühen 20. Ist der schon ausgegraben worden und ist halt eben in diese Ausstellung gekommen. Und das Spannende an dem ist, oder das Interessante, oder was ihn auszeichnet, da sind mehrere feine Linien drauf zu sehen. Der ist so 21 mal 14 Zentimeter groß, also jetzt auch nicht riesig. Und wie gesagt, Walter Christ hat sich das angesehen und dachte dann sofort, oh oh, ist das nicht vielleicht ein Spiel?

Elli:

In einem Artikel der Universität Leiden sagt er dazu auch was und ich zitiere das mal kurz. Das Erscheinungsbild des Steins deutet zusammen mit den Abnutzungsspuren stark auf ein Spiel hin. Doch ich erkannte das Muster aus keinem der anderen antiken Spiele, die mir bekannt sind.

Caspar:

Es ist wohl so, dass auf diesem Stein Steinchen, kleine Steinchen gelegt wurden auf diese Linien, aber man wusste halt nicht, wie genau das Spiel funktioniert, wie die Regeln sind, wer das Spiel am Ende gewinnt. Das war völlig unklar, weil überraschenderweise es lag keine Anleitung daneben.

Elli:

Ich muss direkt so ein bisschen an Mühle denken, bei so Linien und Steinchen, die man irgendwie auf Linien legt. Ja, ja.

Caspar:

Es geht tatsächlich auch in die Richtung, aber das wusste man halt noch nicht, als der Stein entdeckt wurde.

Elli:

Und warum man das jetzt weiß oder zumindest denkt es zu wissen, so ganz genau wissen wir ja nie, ob das dann am Ende stimmt, das ist tatsächlich KI.

Caspar:

Ja, die Technologie kommt ins Spiel. Ein Team aus Forschenden aus den Niederlanden, Belgien und Australien hat ein KI-Modell genutzt, um die Regeln zu rekonstruieren. Und zwar nicht irgendeines, sondern Ludii. Das ist ein KI-gestütztes Spielsystem der Universität Maastricht. Und die Forschenden haben quasi dieser Spiele-KI diesen Stein vorgelegt und haben der KI gesagt, du bist jetzt zwei Gegenspieler, die an diesem Spielbrett gegeneinander antreten. Versucht doch mal alle möglichen Regeln von historischen Spielen, die wir euch mitgeben aus Europa. Versucht doch mal irgendwie, ob ihr es hinkriegt, ihr beiden, dieses Spiel mal anfangen zu spielen.

Elli:

Da hat direkt der sehr lange vergangene Lateinunterricht in meinem Gehirn übrigens geklingelt. Ludii. Das ist ja, also Ludii ist doch glaube ich auch das Spiel. Ludere spielen.

Caspar:

Ja bitte, die klingeln ja mal durch. Genau. Und das war relativ überraschend, weil die Abnutzungsspuren und die Spielregeln, die die zwei KI-Agenten dann gewählt haben, die auch funktionieren auf diesem Spielbrett, sind wahrscheinlich ein sogenanntes Blockierspiel. Also ein Brettspiel, bei dem das Ziel darin besteht, den Gegner an weiteren Zügen zu hindern. So ein bisschen ähnlich wie Mühle auch. Jetzt kann man sagen, okay, was ist daran so besonders? Das ist ja ein relativ altes Spielprinzip, ja. Aber bisher dachte man eigentlich, dass das frühestens im Mittelalter erfunden wurde. Und jetzt hat man eben den Beweis, das gab es schon vor 1500 bis 1700 Jahren. Und damit ist das dann schon ein relativ großer Fund, der in diesem Museum für eine Therme relativ unscheinbar in der Ecke lag, bis ein Experte für Spiele mal um die Ecke kam und zwei KI-Modelle mit dem Stein dann gespielt haben.

Elli:

Ich finde das eine sehr, sehr süße Geschichte auch. Also ich liebe auch, dass es Menschen gibt, die hauptberuflich sich mit historischen Spielen beschäftigen können. Das macht mich ein bisschen happy. Das bringt Spaß rein. Ich hoffe, ihr hattet auch Spaß beim Hören dieser guten Nachricht. Und insgesamt an unserer Folge. Wir sind von Hacks über Produktivitäts-KI-Tracking. Träume, Wünsche. Ja, Ideen, Produktivitätsideen. Über Roboter bis hin zum Spielen gekommen. Ich fand, das war eine bunte Folge. Und dann bleibt uns gar nicht mehr so viel zu sagen, Caspar, oder?

Caspar:

Nee, ich glaube, ich hole jetzt mal ein Mühle-Brett raus. Ich habe Mühle, glaube ich, seit 40 Jahren nicht mehr gespielt. Ich probiere das mal wieder aus.

Elli:

Und ich spiele heute, glaube ich, nichts mehr. Nee, reicht dann auch.

Caspar:

In diesem Sinne, habt eine schöne Woche.

Elli:

Wir hören uns nächste Woche wieder.

Caspar:

Genau.

Elli:

Selbe Stelle, selbe Welle.

Caspar:

Richtig.

Elli:

Bis dahin.

Caspar:

Tschüss.

Elli:

Lasst es euch gut gehen. Werdet nicht krank. Passt auf euch auf.

Caspar:

Oh Gott, ja. Klopfen wieder auf Holz.

Elli:

Tschüss.

Jingles:

Das war's schon wieder für diese Woche. Folgt oder abonniert uns gerne in eurer Podcast-App und lasst uns dort eine Bewertung da. Das hilft uns sehr. Bis zum nächsten Mal.